–> Blogbeitrag auf Deutsch lesen

Contribution by Mònica Feixas

Artificial Intelligence both fascinates and frightens us in equal measure. For some, AI is the biggest threat to academic integrity in a generation; for others, the most powerful learning tool since the printing press. In this blog, I would like to invite you to look closely at how universities are talking about AI in their policies and practices. To make sense of these approaches, I propose the Triple A Approach — Awareness, Agency, Action:

- Awareness: recognising how AI is framed in policies, understanding the narratives and surfacing the assumptions and biases.

- Agency: keeping humans, teachers and students, in control. AI doesn’t replace critical thinking; it makes it more urgent.

- Action: moving from theory to practice by redesigning assessment, integrating AI thoughtfully in teaching, and building AI and epistemic literacy for critical, ethical use.

Awareness: What Policies Reveal

When we examined 14 university policies on generative AI in Spain and Switzerland, we found that policies don’t just regulate, they tell stories about students, teachers, and knowledge:

- Definitions matter: Policies define AI as a tool or resource (like a dictionary), most as a risky system, a partner in thinking, or even a transformative force. These assumptions shape how integrity and assessment are imagined.

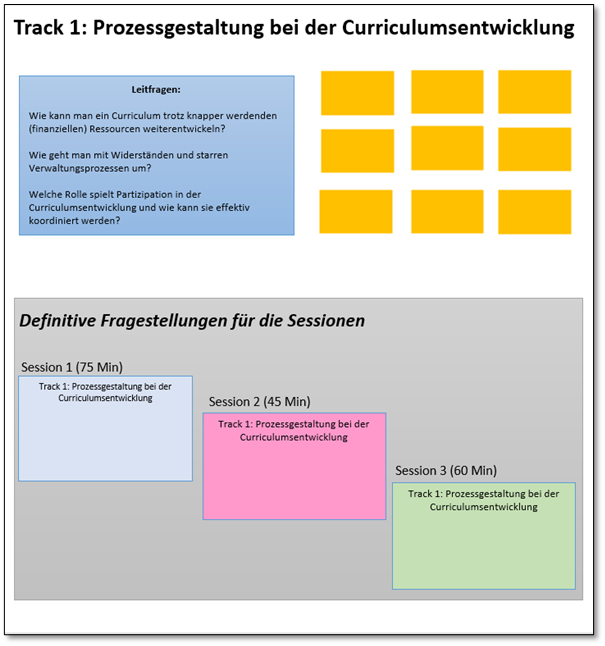

- Narratives Shape Integrity (Table 1):

- Restrictive policies treat AI mainly as a threat, focusing on «fraud» and «detection.» Students are framed as potential cheaters, teachers as enforcers, and integrity becomes surveillance.

- Enabling policies see AI as a learning opportunity, requiring students to disclose and reflect on AI use, and teachers to rethink assessment. Integrity is about guidance, honesty, and transparency.

| In restrictive policies: – AI = Academic Dishonesty – Students as cheaters, will misuse tools unless strictly regulated. Assumed unmotivated, short-cut seeking – Traditional formats = inherently trustworthy – Teachers expected to police – Focus of Academic Integrity is on detection and surveillance | In non-restrictive policies: – AI = Opportunity for learning and Pedagogical innovation – Students as active, critical thinkers. Must be trained in ethical use and new literacies – Assessment = process + reflection – Teachers as mentors and designers, and irreplaceable – Focus of Academic Integrity is on guidance and reflection |

These narratives shape the university’s culture. Are students potential fraudsters or responsible learners? Are teachers detectives or mentors? Answers to these questions define how we understand integrity and pursue student agency.

Redefining Academic Integrity

Why do students cheat? Research (Eaton et al, 2017) shows cheating is driven by a mix of factors: Stress, unrealistic or unclear assessments, or peer pressure. Many students also don’t always understand academic expectations.

In drawing on Rhode’s (2017) study, Eaton et al, remind us that only a small fraction of students never cheat and a similarly small minority cheat intentionally and consistently; the majority — about 80–90% — sit in the middle, meaning they cut corners when under pressure, often regretting it afterwards.

With AI, although still many students are cautious, most don’t view its use as cheating, unless boundaries are clear. Where is the line between «acceptable help» from AI and actual misconduct? Most universities treat unauthorized use (AI uses in a way that is not allowed by the course or institution) or undisclosed (fail to acknowledge) as misconduct, like plagiarism. So they stress transparency: students are expected to acknowledge how AI was used. This is a rather compliance-based view of integrity: focused on rules, detection, enforced through surveillance and sanctions.

In this regard, academic integrity is not just about what students shouldn’t do, but about what the whole academic community does — building trust, respect, practicing fairness, and taking responsibility in knowledge work. This cannot rely on punishment alone; it needs a learning culture and AI literacy.

Agency: Who is in Control?

AI literacy is not just about knowing how to use AI tools, it’s about having agency: the ability to make informed choices, exercise ethical and critical judgment, and be recognized as an active participant (Emirbayer & Mische, 1998; Bandura, 2001). Without agency, we risk outsourcing too much of our thinking to machines.

1. Who is in control: humans or machines?

AI can either undermine or enhance our agency. If students use AI uncritically, they may lose creativity and cognitive skills. But if they engage critically, AI can become a tool for deeper learning. Teachers face the same choice: lose agency by policing students’ AI use; gain agency by designing innovative teaching and learning activities that require reflection, evaluation, and critical thinking.

2. What happens to thinking when we rely too much on AI?

The main risk is what some call cognitive atrophy or brain drain (Guest et al. 2025): when we outsource too much mental effort, our capacity for deep thinking shrinks.

- Cognitive offloading can free working memory for higher-order thinking but overuse weakens memory and reasoning (Oakley et al., 2025).

- Productive struggle is essential: learning needs challenge and effort with scaffolding (Hattie et al., 2023). If AI removes this, students lose resilience and critical capacity.

Guest et al. (2025) show AI may raise abstraction levels but reduce effort and depth of thinking. Experts may benefit from using AI to «chunk» tasks, but novices risk dependency. This can widen inequalities between confident students who use AI to push boundaries and those who let it do the work for them.

3. How do we protect human agency in the age of AI?

The biggest danger is over-trust: those who rely blindly on AI lose the most independence. As systems improve, the temptation to trust them fully will grow. Protecting agency means:

- Cultivating skepticism: teaching students to question AI outputs.

- Designing for thinking: creating tasks that require evaluation, judgment, and reflection.

- Preserving independence: making space for the struggle that builds knowledge, resilience, and critical capacity.

AI is not going away, and we shouldn’t embrace it uncritically. Instead, we can treat it as an opportunity. The challenge is to cultivate integrity at scale: to see students as capable learners, teachers as trusted professionals, and institutions as communities of care.

If we build epistemic agency into our curricula, AI can become a tool for growth, helping students develop literacy, responsibility, and higher-order thinking, rather than a shortcut to superficial answers.

Action: Redesign for the Future

If Awareness uncovers assumptions and Agency protects the capacity to think and act critically, then Action must show how integrity can be redesigned at scale. To the question «What are scholarly pathways to design for academic integrity?», there is no single answer, but I suggest three areas for action: pedagogy, governance and community building – themes we will explore in the upcoming events below.

Pedagogy

- Redesign assessments to include process-oriented formats (reflections, version histories, journals, portfolios, or oral explanations that reveal thinking, not just final products).

- Reframe authorship: Ask students to document their AI use and reflect on how it shaped their thinking and work and why.

- Promote transparency: communicate clearly when and how AI can be used.

- Foster AI literacy: teach the basics of AI including data protection, critical evaluation and ethical use.

- Assess epistemic literacy: Can students justify when and why they used (or did not use) AI?

Governance

As mentioned in the study:

- Policies must be clear about when AI can be used, how its use should be documented, and when it must be excluded to protect learning and genuine achievement.

- Should move beyond compliance: not just list what is «allowed» or «forbidden», but:

- articulate clear values of honesty, fairness, and trust.

- see students as responsible agents: not merely as potential cheaters, but as partners in shaping integrity.

- empower teachers: through professional development, infrastructure, and time to experiment with new assessment formats.

- put assessment at the center: because assessment is where integrity is most consequential — it determines recognition, grades, and opportunities.

- Provide clear frameworks for when AI is allowed, guided, or excluded (e.g., University of Sydney’s two-lane model or the AIAS Assessment Scale).

- Support teacher and student agency with AI literacy, professional development and infrastructure.

Community Building

Integrity grows from developing alliances that scale from classroom pilots to institutional strategy:

- Build dialogue and shared responsibility across faculty, students, and administrators.

- Share good practices and pilot projects that strengthen integrity.

- Encourage critical discussion about power, ethics, and AI’s role in knowledge production.

INFOBOX

As we step into this future, I invite you to continue the dialogue in the upcoming events:

- One-day conference: Assessment und KI: Gemeinsam praktische Formate erkunden (PH Zürich, 20th November 2025). An experimental, hands-on event, inviting educators, developers, and students into open dialogue and co-creation around real dilemmas of assessment in the age of AI.

- Fostering Epistemic Agency in Higher Education: Why and How? Free webinar by the Higher Education Development, Teaching and Learning Research Group with Dr. Juuso Nieminen (Deakin University, Australia), 4th November 2025

- The ICED26 Conference «Agency and Academic Development» (Salamanca, 24-26 June 2026). The international conference of academic developers but also researchers and leaders. This time we explore how agency shapes knowledge, strategy, and student learning. How do academic developers cultivate agency in a rapidly changing higher education landscape?

About the Author

Mònica Feixas is a lecturer and researcher at the Centre for Teaching and Learning in Higher Education at the PH Zurich. She is also the Convenor of ICED (International Consortium for Educational Development) Conference in Salamanca (24–26 June 2026).